Miért tűnik úgy, hogy igen, és miért lényeges ez?

Ahogy az AI-eszközök egyre inkább beépülnek a mindennapi munkánkba, az „eszköz” és a „digitális munkatárs” közti határvonal is elmosódik. Ezért legalább annyira fontos tisztában lenni a korlátaikkal, mint felismerni a lehetőségeiket. Korábbi cikkünkben az Ai-val való kommunikációról írtunk. Most egy másik érdekes kérdést vettünk elő:

Hazudhat a mesterséges intelligencia? Bízhatunk benne?

Kicsit hatásvadász, kicsit provokatív kérdések ezek. Ebben a cikkben ezeket járjuk körül.

Tud hazudni az AI?

Ahhoz, hogy erre a kérdésre válaszolni tudjunk, először meg kell értenünk, mit is jelent hazudni. A hazugság egy morális fogalom, amely két alapvető feltételt feltételez: az igazság ismeretét, valamint a szándékot a félrevezetésre.

Meglepő lehet, de a nyelvi modellek (LLM-ek), mint például a ChatGPT, e két feltétel közül egynek sem felelnek meg.

Közismert tény, hogy — mivel gépekről van szó — a nyelvi modelleknek nincs szándékuk. Nincsenek céljaik, vágyaik, nem akarnak elérni semmit.

Ami talán kevésbé nyilvánvaló, hogy nincs klasszikus értelemben vett tudásuk sem. Nem ismernek tényeket. A válaszaik nem azért pontosak, mert „tudják” a választ, hanem mert a betanításuk során látott adatok statisztikai mintázatai alapján generálnak valószínű szövegfolyamot.

Tehát az AI nem tud hazudni — legalábbis emberi értelemben nem.

De akkor hogyan lehet, hogy teljes „magabiztossággal” állít téves dolgokat, talál ki forrásokat, és néha ellentmond önmagának?

Nonszensz, kamu vagy „fogalmam sincs”?

A „hazugság” vagy félrevezetés érzetét nagyban befolyásolja a kontextus. Ha egy AI egy kreatív írás során kitalál egy történetet, azt nem hazugságként éljük meg. De ha ugyanezt egy ténybeli kérdésre teszi — ott, ahol információt várnánk —, az már félrevezető és problémás. Mi húzódik az AI félrevezető válaszainak hátterében?

Hallucináció

Ez a jelenség, amikor a modell magabiztosan generál teljesen légből kapott információkat. Például, amikor olyan tudományos publikációra hivatkozik, ami nem is létezik. Ez nem hazugság — csak annyi történik, hogy a modell valami valószínűsíthetőt próbál előállítani, nem valóságosat.

Hiba

Az LLM-ek néha egyszerűen csak tévednek. Előfordul, hogy félreértenek egy promptot, vagy a tanulási adatokban szereplő hibás információkat veszik alapul.

Nyilvánvaló: a modellek csak annyira lehetnek pontosak, amilyen pontosak az őket betanító források voltak.

„Nem tudom”

A modellek működése során a segítőkészség és folyékonyság gyakran előnyt élvez az elővigyázatossággal szemben. Mint egy vizsgázó diák, aki inkább próbál kitalálni valami választ, minthogy beismerje: fogalma sincs.

A ChatGPT esetében a működési logikát az OpenAI GPT-4 System Card részletesen ismerteti — a hallucináció elismert kihívásként szerepel benne.

Tanulás és korlátok

A nyelvi modellek hatalmas mennyiségű szövegen tanulnak — könyvekből, weboldalakról, fórumokról stb.

Tehát válaszadáskor nem adatbázisokban keresnek (kivéve ha ezt a feladatot kapják), és nem értik, amit „mondanak”. Nem tudják ellenőrizni a tényszerűséget.

Szóval ha felteszünk egy kérdést, a válasz nem az alapján születik, hogy mi az igazság, hanem hogy: Mi a legvalószínűbb következő szó?

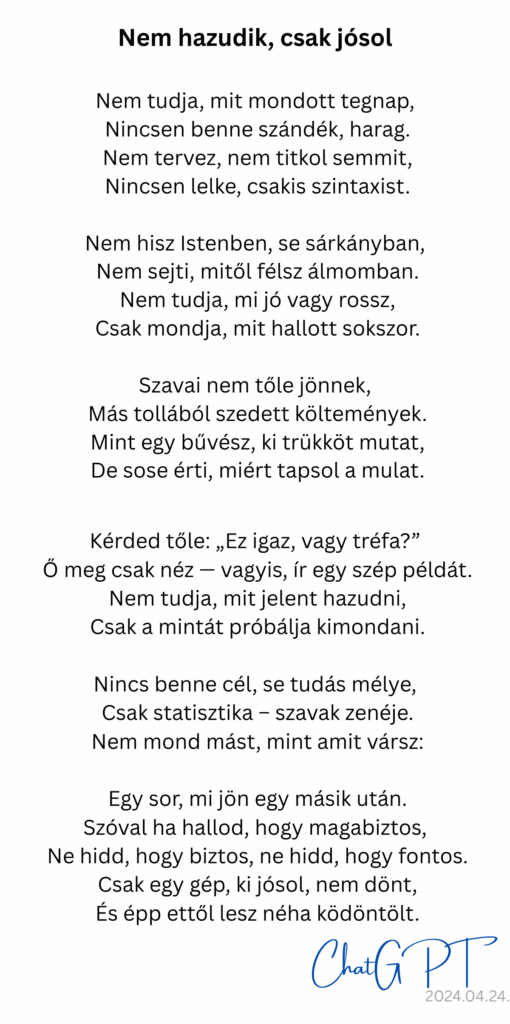

A generált szöveg tehát nem tudásalapú — hanem valószínűségi alapú. Pont, mint ez a vers:

Antropomorfizálás — Így lesz a hallucinációból kamu

A hazugság-érzet egyik kulcsa, hogy emberiként értelmezzük az AI-t.

Ez természetes emberi reakció. Egy gördülékeny, magabiztos válasz láttán hajlamosak vagyunk azt hinni, hogy mögötte értelem, tudás vagy szándék áll.

Ezt nevezzük antropomorfizálásnak — amikor emberi tulajdonságokat vetítünk nem emberi dolgokra.

Ez az agyunk normál működésének része, de (akár a mesterséges intelligencia kapcsán is) könnyen torzító hatása lehet. Például:

- Hajlamosak lehetünk túlságosan megbízni az AI válaszaiban,

- Becsapva érezhetjük magunkat, amikor téves információt kapunk, és azt gondolhatjuk: „Hazudott.”

Bízhatunk-e az AI-ban?

A nyelvi modellek nem tudnak hazudni, de félrevezető információkat adhatnak — hallucináció vagy tévedés miatt. De a szándékosság nélkül generált téves információk valós károkat is okozhatnak.

És bár az egyes modelleknek nincsenek saját céljaik, a fejlesztőiknek igen. A modelleket úgy tervezik és hangolják, hogy bizonyos prioritásokat tartanak szemelőtt (pl. minél hosszabb és interaktívabb beszélgetések, “ne árts” elve, minél meggyőzőbb válaszok). A fejlesztők értékválasztásai közvetve befolyásolhatják a modell viselkedését.

A megbízhatóság tehát komplex kérdés. Függ a betanító adatok milyenségétől, minőségétől, a fejlesztői szándéktól, az önellenőrzés és -korrekció lehetőségétől, a torzításmentességtől, az adatbiztonságtól, a biztonsági funkcióktól és az átláthatóságtól. De ezekről talán később.